6 Un exemple - le PC

Le terme PC (Personal Computer) a

Le terme PC (Personal Computer) a

été introduit en 1981 lorsque la firme IBM (Internal Business Machines) a commercialisé pour la première fois un ordinateur personnel destiné à une utilisation familiale.

Depuis, les domaines d’application du PC ont énormément évolué…. De la gestion de production à la gestion de systèmes d’acquisition, en passant par la reconnaissance de forme ou le traitement de l’image, ses domaines d’utilisation sont extrêmement riches et variés. Pour cela, le PC est défini par une architecture minimale laissant la liberté à chacun de rajouter les périphériques d’entrée/sorties nécessaires à

l’utilisation visée, qu’elle soit familiale ou professionnelle. Un PC est composé par une unité centrale associée à des périphériques (clavier, moniteur, carte d’acquisition, etc…)

6.1 L’unité centrale

Elle est composée par :

La carte mère

La carte mère

Le microprocesseur

Le microprocesseur

La mémoire

La mémoire

La carte vidéo

La carte vidéo

Les périphériques internes de stockage

Les périphériques internes de stockage

6.1.1 La carte mère

La carte mère est l'un des éléments essentiels d'un ordinateur. Elle assure la connexion physique des différents composants (processeur, mémoire, carte d'entrées/sorties, ...) par l’intermédiaire de différents bus (adresses, données et commande). Plusieurs technologies de bus peuvent se côtoyer sur une même carte mère. La qualité de la carte mère est vitale puisque la performance de l’ordinateur dépend énormément d’elle. On retrouve toujours sur une carte mère :

le chipset : c’est une interface d’entrée/sortie. Elle est constituée par un jeu de plusieurs composants chargé de gérer la communication entre le microprocesseur et les périphériques. C’est le lien entre les différents bus de la carte mère.

le chipset : c’est une interface d’entrée/sortie. Elle est constituée par un jeu de plusieurs composants chargé de gérer la communication entre le microprocesseur et les périphériques. C’est le lien entre les différents bus de la carte mère.

le BIOS (Basic Input Ouput Service) : c’est un programme responsable de la gestion du matériel : clavier, écran, disques durs, liaisons séries et parallèles, etc... Il est sauvegardé dans une mémoire morte (EEPROM) et agit comme une interface entre le système d’exploitation et le matériel.

le BIOS (Basic Input Ouput Service) : c’est un programme responsable de la gestion du matériel : clavier, écran, disques durs, liaisons séries et parallèles, etc... Il est sauvegardé dans une mémoire morte (EEPROM) et agit comme une interface entre le système d’exploitation et le matériel.

l’horloge : elle permet de cadencer le traitement des instructions par le microprocesseur ou la transmission des informations sur les différents bus.

l’horloge : elle permet de cadencer le traitement des instructions par le microprocesseur ou la transmission des informations sur les différents bus.

les ports de connexion : ils permettent de connecter des périphériques sur les différents bus de la carte mère. Il existe des ports « internes » pour connecter des cartes d’extension (PCI, ISA, AGP) ou des périphériques de stockage (SCSI, IDE, Serial ATA) et des ports « externes » pour connecter d’autres périphériques (série, parallèle, USB, firewire, etc …)

les ports de connexion : ils permettent de connecter des périphériques sur les différents bus de la carte mère. Il existe des ports « internes » pour connecter des cartes d’extension (PCI, ISA, AGP) ou des périphériques de stockage (SCSI, IDE, Serial ATA) et des ports « externes » pour connecter d’autres périphériques (série, parallèle, USB, firewire, etc …)

Le socket : c’est le nom du connecteur destiner au microprocesseur. Il détermine le type de microprocesseur que l’on peut connecter.

Le socket : c’est le nom du connecteur destiner au microprocesseur. Il détermine le type de microprocesseur que l’on peut connecter.

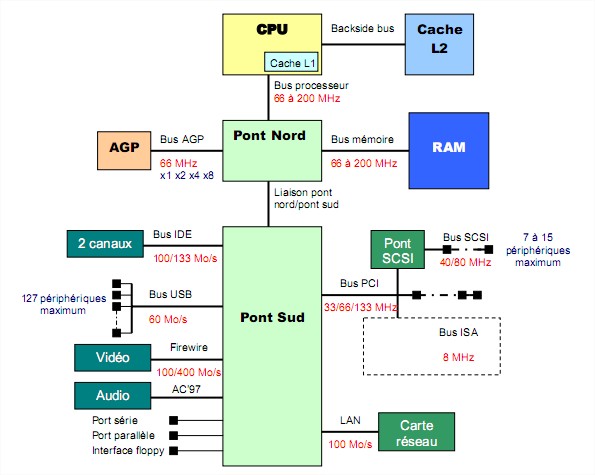

Architecture d’une carte mère

Ici le chipset est composé par deux composants baptisé Pont Nord et Pont Sud. Le pont Nord

s’occupe d’interfacer le microprocesseur avec les périphériques rapides (mémoire et carte graphique) nécessitant une bande passante élevée alors que le pont sud s’occupe d’interfacer le

microprocesseur avec les périphériques plus lents (disque dur, CDROM, lecteur de disquette, réseau, etc…).

On voit apparaître différents bus chargés de transporter les informations entre le

microprocesseur et la mémoire ou les périphériques :

Bus processeur : on l’appelle aussi bus système ou FSB (Front Side Bus). Il relie le microprocesseur au pont nord puis à la mémoire. C’est un bus 64 bits.

Bus processeur : on l’appelle aussi bus système ou FSB (Front Side Bus). Il relie le microprocesseur au pont nord puis à la mémoire. C’est un bus 64 bits.

Bus IDE : il permet de relier au maximum 2 périphériques de stockage interne par canal (disque dur ou lecteur DVDROM/CDROM). Son débit est de 133 Mo/s. Lorsque 2 périphériques sont reliés sur le même canal, un doit être le maître (prioritaire sur la prise du bus) et l’autre l’esclave.

Bus IDE : il permet de relier au maximum 2 périphériques de stockage interne par canal (disque dur ou lecteur DVDROM/CDROM). Son débit est de 133 Mo/s. Lorsque 2 périphériques sont reliés sur le même canal, un doit être le maître (prioritaire sur la prise du bus) et l’autre l’esclave.

Bus PCI (Peripheral Component Interconnect) : Il a été créé en 1991 par Intel. Il permet de connecter des périphériques internes. C’est le premier bus à avoir unifier l’interconnexion des systèmes d’entrée/sortie sur un PC et à introduire le système plug-and-play. Il autorise aussi le DMA. C’est un bus de 32 bits. On retrouve une révision du bus PCI sur les cartes mères de serveur ayant une largeur de bus de 64 bits et une fréquence de 133 MHz.

Bus PCI (Peripheral Component Interconnect) : Il a été créé en 1991 par Intel. Il permet de connecter des périphériques internes. C’est le premier bus à avoir unifier l’interconnexion des systèmes d’entrée/sortie sur un PC et à introduire le système plug-and-play. Il autorise aussi le DMA. C’est un bus de 32 bits. On retrouve une révision du bus PCI sur les cartes mères de serveur ayant une largeur de bus de 64 bits et une fréquence de 133 MHz.

Bus AGP (Accelered Graphic Port) :. Il a été créé en 1997 lors de l’explosion de l’utilisation des cartes 3D qui nécessitent toujours plus de bandes passantes pour obtenir des rendus très réalistes. C’est une amélioration du bus PCI. Il autorise en plus le DIME (DIrect Memory Execution) qui permet au processeur graphique de travailler directement avec les données contenues dans la RAM sans passer par le microprocesseur à l’instar d’un DMA. C’est un bus 32 bits et son débit maximum est de 2 Go/s (en x8).

Bus AGP (Accelered Graphic Port) :. Il a été créé en 1997 lors de l’explosion de l’utilisation des cartes 3D qui nécessitent toujours plus de bandes passantes pour obtenir des rendus très réalistes. C’est une amélioration du bus PCI. Il autorise en plus le DIME (DIrect Memory Execution) qui permet au processeur graphique de travailler directement avec les données contenues dans la RAM sans passer par le microprocesseur à l’instar d’un DMA. C’est un bus 32 bits et son débit maximum est de 2 Go/s (en x8).

Bus ISA (Industry Standard Architecture) : C’est l’ancêtre du bus PCI. On ne le

Bus ISA (Industry Standard Architecture) : C’est l’ancêtre du bus PCI. On ne le

retrouve plus sur les nouvelles générations de cartes mères.

Bus SCSI (Small Computer System Interface) : c’est un bus d’entrée/sortie parallèle

Bus SCSI (Small Computer System Interface) : c’est un bus d’entrée/sortie parallèle

permettant de relier un maximum de 7 ou 15 périphériques par contrôleur suivant la

révision du protocole utilisée. C’est une interface concurrente à l’IDE qui présente

l’avantage de pouvoir connecter plus de périphériques pour des débits supérieurs. En

outre, ces périphériques peuvent partager le bus lors d’un dialogue contrairement à

l’IDE. Mais son coût reste très élevé… elle est utilisée pour les serveurs.

Bus USB (Universal Serial Bus ) : c’est un bus d’entrée/sortie plug-and-play série.

Bus USB (Universal Serial Bus ) : c’est un bus d’entrée/sortie plug-and-play série.

Dans sa deuxième révision (USB 2.0), il atteint un débit de 60 Mo/s. Un de ces

avantages est de pouvoir connecter théoriquement 127 périphériques. Il supporte de

plus le hot plug-and-play (connexion ou déconnexion de périphériques alors que le

PC fonctionne).

Bus firewire : c’est un bus SCSI série. Il permet de connecter jusqu’à 63

Bus firewire : c’est un bus SCSI série. Il permet de connecter jusqu’à 63

périphériques à des débits très élevés (100 à 400 Mo/s). Ces applications sont

tournées vers la transmission de vidéos numériques.

Liaison pont nord/pont sud : ses caractéristiques dépendent du chipset utilisé.

Liaison pont nord/pont sud : ses caractéristiques dépendent du chipset utilisé.

Chaque fabricant a en effet développé une solution propriétaire pour connecter les

deux composants de leur chipset. Pour Intel, c’est Intel Hub Architecture (IHA) dont

les débits atteignent 533 Mo/s. Pour Nvidia (en collaboration avec AMD), c’est

l’HyperTransport qui atteint des débits de 800 Mo/s.

Remarques :

Tous les bus « internes » (PCI, IDE, AGP) vont être amenés à disparaître très rapidement

Tous les bus « internes » (PCI, IDE, AGP) vont être amenés à disparaître très rapidement

et seront remplacés par des bus série :

Le Serial Ata, remplaçant du bus IDE, présente des débits de 150 Mo/s qui passeront bientôt à 300 Mo/s dans la prochaine révision du bus. Il permet de connecter des disques durs ou des lecteurs optiques.

Le Serial Ata, remplaçant du bus IDE, présente des débits de 150 Mo/s qui passeront bientôt à 300 Mo/s dans la prochaine révision du bus. Il permet de connecter des disques durs ou des lecteurs optiques.

Le PCI Express, remplaçant des bus PCI et AGP, permet d’atteindre des débits de 250 Mo/s dans sa version de base qui peuvent monter jusqu’à 8Go/s dans sa version x16 destinée à des périphériques nécessitant des bandes passantes très élevées (application graphique).

Le PCI Express, remplaçant des bus PCI et AGP, permet d’atteindre des débits de 250 Mo/s dans sa version de base qui peuvent monter jusqu’à 8Go/s dans sa version x16 destinée à des périphériques nécessitant des bandes passantes très élevées (application graphique).

Les bus de connexions filaires tendent à être remplacés par des systèmes de communications sans fils. A l’heure actuelle, il existe :

Les bus de connexions filaires tendent à être remplacés par des systèmes de communications sans fils. A l’heure actuelle, il existe :

le Bluetooth qui offre actuellement un débit de 1 Mb/s pour une portée d’une dizaine de mètre et qui va servir à connecter des périphériques nécessitant des bandes passantes faibles (clavier, souris, etc…).

le Bluetooth qui offre actuellement un débit de 1 Mb/s pour une portée d’une dizaine de mètre et qui va servir à connecter des périphériques nécessitant des bandes passantes faibles (clavier, souris, etc…).

le WIFI (WIreless FIdelity Network) qui permet de connecter des ordinateurs en réseau. La dernière révision permet des débits de 54 Mb/s.

le WIFI (WIreless FIdelity Network) qui permet de connecter des ordinateurs en réseau. La dernière révision permet des débits de 54 Mb/s.

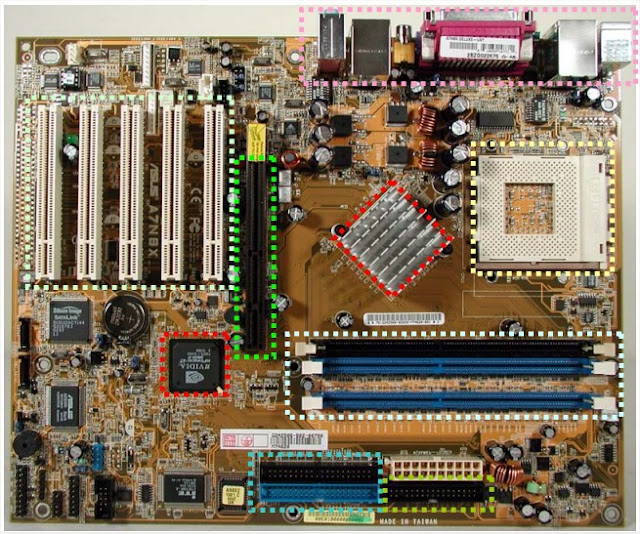

Exemple : Carte mère ASUS A7N8X

6.1.2 Le microprocesseur

6.1.2 Le microprocesseur

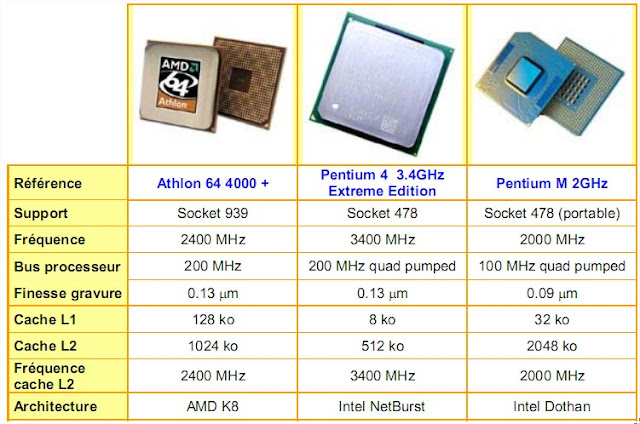

Le microprocesseur est bien entendu l’élément essentiel du PC. Nous avons vu que les performances d’un microprocesseur étaient liées à son architecture et sa fréquence de fonctionnement. A l’heure actuelle, le marché des microprocesseurs pour PC est dominé par deux principaux constructeurs : Intel et AMD. Ceux-ci ont adopté deux stratégies différentes pour réaliser des microprocesseurs toujours plus performants. Intel, fort de son savoir faire, a choisi de fabriquer des microprocesseurs toujours plus rapide en terme de fréquence de fonctionnement alors qu’AMD essaie plutôt d’optimiser ses architectures afin qu’elles soient capables d’exécuter toujours plus d’instructions par cycle d’horloge. Ces deux optiques se retrouvent dans les références des microprocesseurs de chaque marque. Lorsqu’Intel désigne chaque nouveau microprocesseur par sa fréquence, AMD préfère utiliser un P-Rating se référant aux performances des microprocesseurs Intel. Chaque fondeur utilise des sockets et des chipsets différents pour leurs microprocesseurs. Ainsi, le choix d’un microprocesseur impose forcément un choix sur un type de carte mère. Pour connaître les performances d’un microprocesseur, il ne faut donc pas se fier à la seule valeur de sa fréquence de fonctionnement. Il faut prendre en compte toutes les caractéristiques liées à son architecture et ne pas oublier de l’entourer d’un chipset et d’une mémoire performants. La dernière chose à ne pas omettre lorsqu’on choisit un microprocesseur est son système de refroidissement. En effet, plus la fréquence augmente et plus la dissipation thermique sera importante. Un microprocesseur mal refroidit peut entraîner des dysfonctionnements au sein du PC voir même la destruction du microprocesseur lui même. Il faut prévoir un système d’air cooling (ventilateur + radiateur ou heat pipe) ou de water cooling (circuit de refroidissement à eau).

Exemple : Microprocesseur haut de gamme Décembre 2004

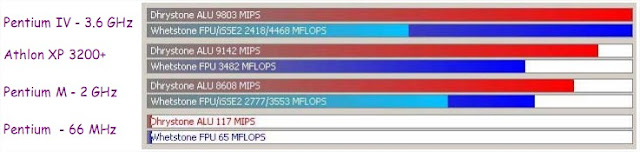

Exemple : Performance en MIPS (traitement entier) et MFLOPS (traitement réel) de différents microprocesseurs.

6.1.3 La mémoire

La qualité et la quantité de mémoire d’un PC vont permettre, au même titre que le microprocesseur, d’accroître les performances de celui-ci. Si on dispose d’un microprocesseur

performant, encore faut-il que la mémoire puisse restituer ou sauvegarder des informations aussi

rapidement qu’il le désire. La fréquence de fonctionnement de la mémoire est donc un paramètre

essentiel. De même, si on veut réduire le nombre d’accès aux périphériques de stockage secondaire qui sont très lents (disque dur, CDROM, etc…), il faudra prévoir une quantité mémoire principale suffisante.

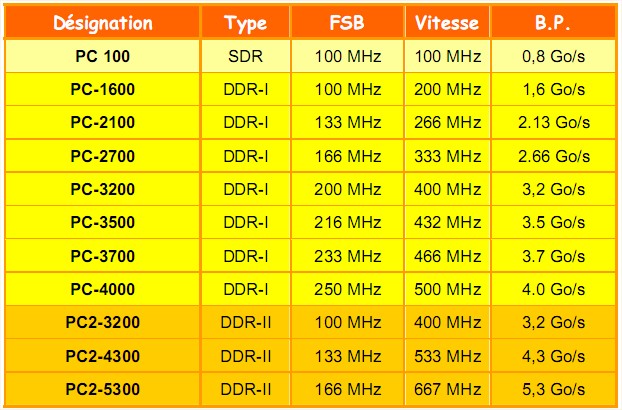

Aujourd’hui, toutes les mémoires que l’on retrouve sur les PC sont des RAM dynamiques (DRAM). Elles sont toutes synchronisées sur l’horloge du bus processeur (FSB). Un boîtier mémoire est constitué de 3 éléments fondamentaux qui sont : La matrice de cellules mémoires

La matrice de cellules mémoires  Les buffers d’entrée/sortie

Les buffers d’entrée/sortie  Le bus de données

Le bus de données

Dans les premières SDRAM, tous les

Dans les premières SDRAM, tous les

ensembles fonctionnaient à 100 MHz. C'est à dire que la cellule mémoire fournissait une information mémoire toutes les 10 ns au buffer d’entré/sortie qui lui même la renvoyait sur le bus à une fréquence de 100 MHz. Comme les DRAM fonctionnent sur 64 bits, on avait une bande passante de 800 Mo/s. Les différentes évolutions de la SDRAM permirent d’atteindre une fréquence de 166 MHz. Actuellement, les technologies de DRAM permettent d’effectuer des accès à la mémoire sur le front montant et descendant de l’horloge (DDR-I

SDRAM) et ainsi de doubler la bande passante mémoire sans en modifier la fréquence de

fonctionnement. Pour cela, il faut bien entendu que la matrice mémoire puisse délivrer 2 informations par cycle d’horloge. Les DDR les plus rapides permettent d’atteindre des fréquences de 200 MHz pour l’accès à la matrice de cellules. Néanmoins, on commence à approcher les limites de fonctionnement du cœur de la mémoire. La prochaine technologie reviendra donc à une fréquence de 100 MHz pour la matrice de cellules mais doublera la fréquence du buffer d’entré/sortie pour compenser (DDR II SDRAM). Il faut donc que le cœur de la mémoire puisse délivrer 4 informations par cycle d’horloge. Tout ceci est rendu possible en divisant le nombre de matrices mémoire. Dans le cas de la SDRAM, la matrice de cellules mémoire est constituée d’un seul bloc physique contre deux pour la DDR-I puis quatre pour la DDR-II.

De plus, de nombreux chipsets permettent de gérer deux canaux d’accès à la mémoire et donc d’accéder simultanément à deux modules de mémoire différents. Le PC sera donc plus performant si il utilise, par exemple, deux barrette de 256 Mo plutôt qu’une seule de 512 Mo. (bus quad pumped d’Intel)

La bande passante est théoriquement doublée si les barrettes sont utilisées en “dual channel”.

6.1.4 La carte vidéo

Le rôle de la carte graphique est de convertir les données numériques à afficher en un signal

compréhensible par un écran . Alors qu'à ses débuts, la carte vidéo se chargeait uniquement d'afficher une simple image formée de points colorées (pixel), les derniers modèles apparus se chargent d'afficher des images en 3D d'une grande complexité. C’est donc un système à microprocesseur à elle seule qui est composée par :

Un GPU (Graphics Processor Unit)

Un GPU (Graphics Processor Unit)

De la mémoire vidéo

De la mémoire vidéo

D’un dispositif de conversion analogique numérique : RAMDAC.

D’un dispositif de conversion analogique numérique : RAMDAC.

D’entrées/sorties vidéo

D’entrées/sorties vidéo

La carte vidéo communique avec la mémoire centrale et le microprocesseur par l’intermédiaire

d’un bus. Actuellement, c’est le bus AGP qui est le plus utilisé mais il va progressivement être

remplacé par le PCI Express qui présente des débits beaucoup plus élevés (8 Go/s contre 2 Go/s).

6.1.4.1 Le GPU

6.1.4.1 Le GPU

Le GPU est le processeur central de la carte graphique.

Il se charge du traitement des données vidéo, permettant ainsi de soulager le microprocesseur. Son rôle est de traiter les objets envoyés par le microprocesseur puis d’en déduire les pixels à afficher. En effet, dans le cas de l’affichage du scène 3D, le microprocesseur communique au GPU les données à afficher sous forme vectorielle. Les objets sont donc définis par une masse de points représentant leurs coordonnées dans l’espace.

Pour afficher un objet à l’écran, le GPU procède en plusieurs étapes :

1. placer les objets dans le repère et leur appliquer des transformations (translation, rotation, etc…)

2. appliquer les effets de lumières sur chaque objet

3. décomposer les objets en petits triangles puis en fragments

4. appliquer des textures et des effets sur les fragments

5. afficher les pixel résultants de l’association des fragments

Pour cela, il est constitué d’un immense pipeline principal. Celui-ci comprend au moins un vertex

shader (étape 1 et 2), un setup engine (étape 3) et un pixel shader (étape 4 et 5).

Remarques :

Toutes ces opérations doivent être effectuées pour tous les pixels de la scène à afficher.

Toutes ces opérations doivent être effectuées pour tous les pixels de la scène à afficher.

Pour une image en 1600x1200, cela fait 1 920 000 pixels à calculer, soit près de 6 millions de

fragments !!!! D’autant plus que pour bien faire, le GPU doit être capable d’afficher 50 images/s soit

calculer 300 millions de fragments par seconde… Ceci explique pourquoi les GPU des cartes 3D

récentes sont plus complexes que les derniers microprocesseurs. Pour utiliser au mieux les capacités des cartes graphiques ont dispose d'API (Application

Pour utiliser au mieux les capacités des cartes graphiques ont dispose d'API (Application

Program Interface) qui sont des langages de description et de manipulation des objets :

Direct3D de Microsoft

Direct3D de Microsoft

OpenGL

OpenGL

6.1.4.2 La mémoire vidéo

Elle sert à stocker les images et les textures à afficher. Elle doit présenter des débits très important. Actuellement, la plupart des cartes graphiques sont dotées de DDR SDRAM.

6.1.4.3 Le RAMDAC

Le Ramdac (Random Access Memory Digital Analog Converter) convertit les signaux délivrés

par la carte en signaux analogiques compatibles avec la norme VGA des moniteurs. Plus la fréquence du RAMDAC d'une carte graphique sera élevée, plus le rafraîchissement et la résolution de l'image pourront être élevés. Le confort visuel apparaît à partir d’un rafraîchissement de 72 Hz (fréquence à laquelle sont rafraîchies les lignes à afficher). En principe, la fréquence du RAMDAC est donc de l’ordre de :

Largeur écran x Hauteur écran x fréquence rafraîchissement x 1.32

On rajoute un coefficient de 1.32 à cause du temps perdu par le canon à électron lors de ces déplacements.

Exemple :

Pour une résolution de 1600x1200 à une fréquence de 85Hz, il faudra un RAMDAC de

1600x1200x85x1.32= 215 Mhz !!!

6.1.4.4 Les entrées/sorties vidéo

La sortie vers le moniteur se fait par l’intermédiaire d’une sortie au format VGA. Maintenant, la

plupart des cartes disposent d’une sortie TV au format S-vidéo. Depuis l’explosion des écrans LCD, elles disposent aussi souvent d’un port DVI en plus du port VGA. Le port DVI est numérique et ne nécessite pas la traduction des données par le RAMDAC.

6.1.5 Les périphériques internes de stockage

Ce sont les périphériques de type mémoire de masse. On les appelle ainsi pour leur grande

capacité de stockage permanent. Ces périphériques sont dotés d’un contrôleur permettant de les faire dialoguer avec le microprocesseur. Actuellement, les plus répandus sont l’IDE et le SCSI. Le SCSI présente des débits plus importants que l’IDE (160Mo/s contre 133Mo/s) et permet de connecter plus de périphériques sur le même contrôleur (7 contre 4). Néanmoins, cette technologie étant plus onéreuse, on la retrouve surtout sur des serveurs alors que l’IDE est présent dans tous les PC. A l’heure actuelle, ces deux types de contrôleur sont en fin de vie et sont progressivement remplacés par des contrôleur de type Serial ATA. Ce sont des contrôleurs série dérivés de l’interface IDE qui vont permettent d’atteindre des débits de 600 Mo/s.

Les périphériques internes de stockage sont principalement des périphériques utilisant des supports magnétiques (disque dur) ou optiques (CDROM, DVDROM).

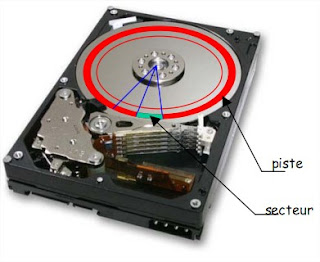

6.1.5.1 Le disque dur

6.1.5.1 Le disque dur

Les disques durs sont capables de

stocker des quantités impressionnantes

d'informations, et surtout de les ordonner et

de les retrouver rapidement.

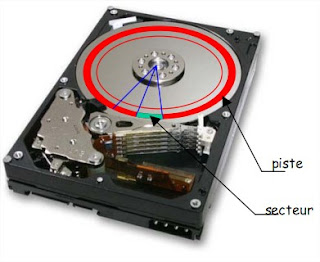

Principe :

Le disque dur est constitué de

plusieurs plateaux empilés, entre lesquels se

déplace un bras comptant plusieurs têtes de

lecture. Chaque plateau est recouvert d'une

surface magnétique sur ses deux faces et

tourne à une vitesse comprise entre 4000 et

15000 tr/min. La tête de lecture/écriture est composée par un aimant autour duquel est enroulée une bobine.

Pour écrire, on fait passer un courant électrique dans la bobine ce qui crée un champ magnétique. Les lignes de champ magnétique traversent la couche d'oxyde et orientent celui-ci en créant de petits aimants dont le sens est donné par le sens du courant dans la bobine.

Pour lire, on fait passer la tête de lecture/écriture sur le support magnétisé qui crée un courant

induit dans la bobine dont le sens indique s'il s'agit d'un 0 ou d'un 1.

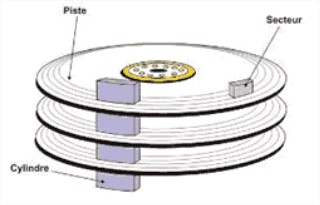

Le formatage :

Le formatage :

Le formatage de bas niveau permet d'organiser la surface du disque en éléments simples (pistes et secteurs) qui permettront de localiser l'information. Le nombre total de pistes dépend du type de disque. Il est effectué en usine lors de la fabrication du disque. Chaque piste est découpée en secteurs. Toutefois l'unité d'occupation d'un disque n'est pas le secteur, trop petit pour que le système puisse en tenir compte. On utilise alors un groupe d'un certain nombre de secteurs (de 1 à 16) comme unité de base. Ce groupe est appelé Bloc ou Cluster. C'est la taille minimale que peut occuper un fichier sur le disque. Pour accéder à un secteur donné, il faudra donc déplacer l'ensemble des bras et attendre ensuite que ce secteur se positionne sous les têtes. L’accès à un bloc est aléatoire alors que l’accès à un secteur est séquentiel.

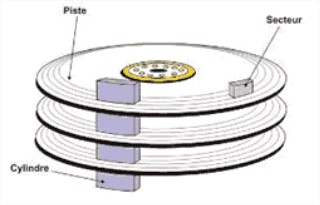

Une autre unité de lecture/écriture est le cylindre. Un cylindre est constitué par toutes les

pistes superposées verticalement qui se présentent simultanément sous les têtes de lecture/écriture.

En effet, il est plus simple d'écrire sur les mêmes pistes des plateaux superposés que de déplacer à

nouveau l'ensemble des bras.

Le formatage de haut niveau permet de créer un système de fichiers gérable par un système

d'exploitation (DOS, Windows, Linux, OS/2, etc ...).

La défragmentation :

A mesure que l'on stocke et supprime des fichiers, la répartition des fichiers sur les différents

clusters est modifiée. L'idéal, pour accéder rapidement à un fichier, serait de pouvoir stocker un fichier sur des clusters contigus sur le même cylindre. La défragmentation permet de réorganiser le stockage des fichiers dans les clusters pour optimiser la lecture.

Les caractéristiques :

capacité en Go

capacité en Go

vitesse de rotation en tours minutes

vitesse de rotation en tours minutes

temps d'accès exprimé en millisecondes

temps d'accès exprimé en millisecondes

interface (IDE, SCSI, SATA)

interface (IDE, SCSI, SATA)

taux de transfert moyen exprimé en Mo par seconde

taux de transfert moyen exprimé en Mo par seconde

A noter que les disques durs actuels sont équipés de cache mémoire afin de diminuer les temps

d’accès.

6.1.5.2 Les disques optiques

Le disque optique numérique résulte du travail mené par de nombreux constructeurs depuis

1970. La terminologie employée varie selon les technologies employées et l’on retrouve ainsi les

abréviations de CD (Compact Disk), CDROM (CD Read Only Memory), CDR, (CD Recordable), DVD (Digital Video Disk), DVDROM (DVD Read Only Memory), etc… Le Compact Disc a été inventé par Sony et Philips en 1981 dans le but de fournir un support audio et vidéo de haute qualité. Les spécifications du Compact Disc ont été étendues en 1984 afin de permettre au CD de stocker des données numériques. En 1990 Kodak met au point le CD-R. Un CD est capable de stocker 650 ou 700 Mo de données et 74 ou 80 min de musique. Le taux de transfert d'un CD-ROM est de 150 ko/s, ce qui correspond au taux de transfert d’un lecteur de CD audio. On peut monter jusqu'à 7200 ko/s (48X) avec un lecteur de CDROM.

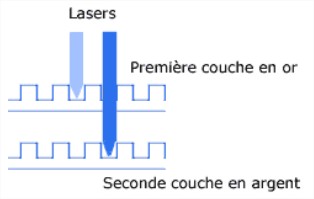

Principe CD-ROM:

Un CD-ROM est un disque de 12 cm de diamètre composé de plusieurs couches superposées :

une couche principale en polycarbonate, un

une couche principale en polycarbonate, un

plastique résistant et laissant passer la lumière

une couche métallique réfléchissante composée de plats et de creux

une couche métallique réfléchissante composée de plats et de creux

une couche de vernis protecteur qui vient protéger le métal de l'agression des UV

une couche de vernis protecteur qui vient protéger le métal de l'agression des UV

Plusieurs technologiesdifférentes existent en fonction du type de CD :

Plusieurs technologiesdifférentes existent en fonction du type de CD :

CD-ROM, CD-R, CD-RW. Le principe de lecture/écriture utilise un rayon infrarouge d'une longueur d'onde de 780 nm.

Lors de la lecture d'un CD, le faisceau laser traverse la couche de

polycarbonate puis rencontre ou non un creux. Lors d’un passage devant un creux, la lumière du laser est fortement réfractée, de telle sorte que la quantité de lumière renvoyée par la couche réfléchissante est minime. Alors que pour un passage devant un plat, la lumière est pratiquement entièrement réfléchie.

Lorsque le signal réfléchi change, la valeur binaire est 1. Lorsque la réflexion est constante, la valeur est 0. A noter que contrairement aux disques durs, un CD n'a qu'une seule piste organisée en spirale.

Cette piste n’est pas régulière mais oscille autour de sa courbe moyenne. La fréquence de ces oscillations est de 22,05 kHz. Cette oscillation permet à la tête de lecture de suivre la courbe et de réguler la vitesse de rotation du CD. Pour l’écriture, il faut utiliser un graveur avec des supports adéquates (CD-R ou CD-RW). Les techniques sont assez similaires qu'il s'agisse d'un CD-R ou d'un CD-RW. Dans le cas d'un CR-R, on ajoute une

Cette piste n’est pas régulière mais oscille autour de sa courbe moyenne. La fréquence de ces oscillations est de 22,05 kHz. Cette oscillation permet à la tête de lecture de suivre la courbe et de réguler la vitesse de rotation du CD. Pour l’écriture, il faut utiliser un graveur avec des supports adéquates (CD-R ou CD-RW). Les techniques sont assez similaires qu'il s'agisse d'un CD-R ou d'un CD-RW. Dans le cas d'un CR-R, on ajoute une

couche de colorant organique pouvant être brûlé par un laser 10 fois plus puissant que le laser requit pour lire un CD. Cette couche de colorant est photosensible. Lorsqu'elle est soumise à une forte lumière, elle l'absorbe et sa température augmente à plus de 250°, ce qui fait qu'elle brûle localement, et crée des plages brûlées et non brûlées. Les creux et bosses du CD classique sont donc ici remplacés par le passage d'une zone brûlée à une zone non brûlée qui réfléchisse plus ou moins de lumière. Pour les CD-RW, on utilise un alliage métallique qui possède la particularité de pouvoir retrouver son état d’origine en utilisant un laser à 200 degrés (effacement).

Les méthodes d’écriture :

Monosession : Cette méthode crée une seule session sur le disque et ne donne pas la possibilité de rajouter des données sur le CD.

Monosession : Cette méthode crée une seule session sur le disque et ne donne pas la possibilité de rajouter des données sur le CD.

Multisession : Cette méthode permet de graver un CD en plusieurs fois, en créant une table des matières (TOC pour table of contents) de 14Mo pour chacune des sessions.

Multisession : Cette méthode permet de graver un CD en plusieurs fois, en créant une table des matières (TOC pour table of contents) de 14Mo pour chacune des sessions.

Track At Once : Cette méthode permet de désactiver le laser entre deux pistes, afin de créer une pause de 2 secondes entre chaque pistes d'un CD audio.

Track At Once : Cette méthode permet de désactiver le laser entre deux pistes, afin de créer une pause de 2 secondes entre chaque pistes d'un CD audio.

Disc At Once : Contrairement à la méthode précédente, le Disc At Once écrit sur le CD en une seule traite. Les musiques sont donc enchaînées.

Disc At Once : Contrairement à la méthode précédente, le Disc At Once écrit sur le CD en une seule traite. Les musiques sont donc enchaînées.

Les techniques de gravures :

Burn Proof ou Just Link : Le problème des graveurs était l'envoi des données à un rythme suffisant. Lorsque les données n’étaient plus présentes dans le buffer du graveur, il y avait une rupture de flux. Ceci entraînait l’arrêt de la gravure par manque de données et le CDR était inutilisable. Pour corriger ce type d'erreurs, les fabricants utilisent maintenant des techniques qui suspendent la gravure lorsque les données ne sont pas présentes, et la reprend dès que les données sont de nouveau présentes dans le buffer. Cette technique est appelée JUST LINK chez la majorité des fabricants, Burn-Proof chez Plextor.

Burn Proof ou Just Link : Le problème des graveurs était l'envoi des données à un rythme suffisant. Lorsque les données n’étaient plus présentes dans le buffer du graveur, il y avait une rupture de flux. Ceci entraînait l’arrêt de la gravure par manque de données et le CDR était inutilisable. Pour corriger ce type d'erreurs, les fabricants utilisent maintenant des techniques qui suspendent la gravure lorsque les données ne sont pas présentes, et la reprend dès que les données sont de nouveau présentes dans le buffer. Cette technique est appelée JUST LINK chez la majorité des fabricants, Burn-Proof chez Plextor.

L'overburning : cette technique permet de dépasser légèrement la capacité du support vierge afin de stocker un peu de données supplémentaires. Pour ce faire, il faut que le logiciel de gravure, ainsi que le graveur, supportent cette technique.

L'overburning : cette technique permet de dépasser légèrement la capacité du support vierge afin de stocker un peu de données supplémentaires. Pour ce faire, il faut que le logiciel de gravure, ainsi que le graveur, supportent cette technique.

Caractéristiques d’un lecteur/graveur :

la vitesse maximum de gravage des CD-R

la vitesse maximum de gravage des CD-R

la vitesse maximum de gravage des CD-RW

la vitesse maximum de gravage des CD-RW

la vitesse maximum de lecture des CD

la vitesse maximum de lecture des CD

interface (IDE, SCSI, SATA)

interface (IDE, SCSI, SATA)

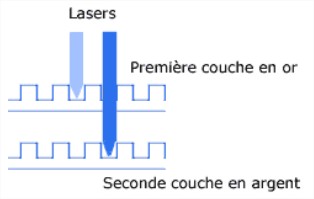

Principe DVDROM :

Principe DVDROM :

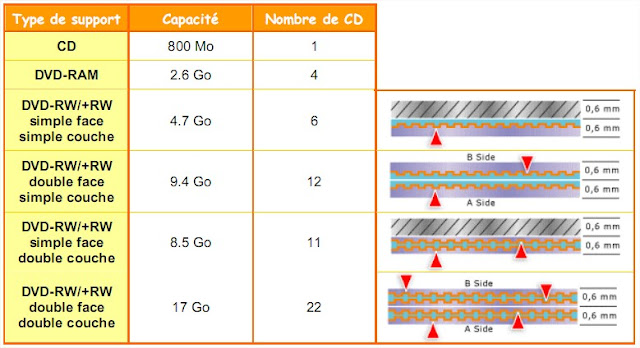

Le DVD-ROM (Digital Versatile Disc - Read Only Memory) est apparu en 1997 et est principalement dédié à la vidéo. C’est en fait un CD-ROM dont la capacité est bien plus grande. En effet, la lecture/écriture est effectuée à partir d’un laser rouge (650 et 635 nm) et permet d’obtenir des creux beaucoup plus petits et donc de stocker plus d’informatons. Les deux longueurs d’ondes utilisées permettent de lire/écrire sur des DVD "double couche". Ces

disques sont constitués d'une couchetransparente et d'une couche réflexive et permettent donc de stocker encore plus d’informations sur un seul CD.

Il existe 3 types de DVD réinscriptibles et incompatibles :

DVD-RAM : le disque simple face permet de stocker 2.6 Go. Il n’est pas compatible avec les lecteurs de salon.

DVD-RAM : le disque simple face permet de stocker 2.6 Go. Il n’est pas compatible avec les lecteurs de salon.

DVD-RW de Sony, Philips et HP permet de stocker 4.7Go par face. Il est entièrement compatible avec les platines de salon.

DVD-RW de Sony, Philips et HP permet de stocker 4.7Go par face. Il est entièrement compatible avec les platines de salon.

DVD+RW est le nouveau standard concurrent au DVD-RW. Il est entièrement compatible avec les platines de salon. Plusieurs marques ont formé une alliance et développent des graveurs DVD présentant des temps d’accès plus faible et des vitesses de gravure plus importante.

DVD+RW est le nouveau standard concurrent au DVD-RW. Il est entièrement compatible avec les platines de salon. Plusieurs marques ont formé une alliance et développent des graveurs DVD présentant des temps d’accès plus faible et des vitesses de gravure plus importante.

Bibliographie

Cours Web :

A brief history of Intel and AMD microprocessors (cours DEUG Université Angers) – Jean-Michel Richer

Architecture Avancée des ordinateurs (cours Supelec Rennes) – Jacques Weiss

Architecture des ordinateurs (cours IUT GTR Montbéliard) – Eric Garcia

Architecture des ordinateurs (cours IUT SRC Marne la Vallée) – Dominique Présent

Architecture des ordinateurs (cours Université Franche Compté) – Didier Teifreto

Architecture des ordinateurs (cours IUP STRI Toulouse)

Architecture des ordinateurs (cours Université de Sherbrooke) – Frédéric Mailhot

Architecture des ordinateurs (cours Polytechnique) – Olivier Temam

Architecture des ordinateurs (cours IUT GTR Villetaneuse) – Emmanuel Viennet

Architecture des ordinateurs (cours DEUG MIAS) – Frédéric Vivien

Architecture des Ordinateurs (cours Licence Informatique USTL) – David Simplot

Architecture des machines et systèmes Informatiques – Joëlle Delacroix

Architectures des processeurs (cours DEUST Nancy) – Yannick Chevalier

Architecture des systèmes à microprocesseurs – Maryam Siadat et Camille Diou

Architecture des systèmes à microprocesseurs (cours IUT Mesures Physiques) – Sébastien Pillement

Architecture Systèmes et Réseaux (cours DEUG 2ième année) – Fabrice Bouquet

Carte graphique (ENIC) – Julien Lenoir

Cours de réseau (cours EISTI) – Bruno Péant

Cours de réseaux (cours Maîtrise Informatique Université Angers) – Pascal Nicolas

Du processeur au système d’exploitation (cours DEUST Nancy) – Yannick Chevalier

Introduction to computer architecture (cours DEUG Université Angers) – Jean-Michel Richer

Les réseaux : introduction (DESS DCISS) – Emmanuel .Cecchet

Les systèmes informatiques (cours CNAM) – Christian Carrez

Sites web :

Fonctionnement des composants du PC

http://www.vulgarisation-informatique.com/composants.php

Cours d’initiation aux microprocesseurs et aux microcontrôleurs

http://www.polytech-lille.fr/~rlitwak/Cours_MuP/sc00a.htm

Architecture des ordinateurs – Université Angers

http://www.info.univ-angers.fr/pub/richer/ens/deug2/ud44/

Les docs de Heissler Frédéric

http://worldserver.oleane.com/heissler/

X-86 secret

http://www.x86-secret.com/

Le cours hardware d’YBET informatique

http://www.ybet.be/hardware/hardware1.htm

Informa Tech

http://informatech.online.fr/articles/index.php

Articles presse :

Mémoire Flash – article Electronique Juillet 98

Les processeurs numériques de signal – article Electronique Janvier 2004

Fonctionnement d’un processeur et d’une carte graphique – article Hardware magazine Novembre

2003

Livres :

Architecture et technologie des ordinateurs (Dunod) – Paolo Zanella et Yves Ligier

Technologie des ordinateurs et des réseaux (Dunod) – Pierre-Alain Goupille

Les microprocesseurs, comment ça marche ? (Dunod) – T. Hammerstrom et G. Wyant

Le terme PC (Personal Computer) a

Le terme PC (Personal Computer) a été introduit en 1981 lorsque la firme IBM (Internal Business Machines) a commercialisé pour la première fois un ordinateur personnel destiné à une utilisation familiale.

Depuis, les domaines d’application du PC ont énormément évolué…. De la gestion de production à la gestion de systèmes d’acquisition, en passant par la reconnaissance de forme ou le traitement de l’image, ses domaines d’utilisation sont extrêmement riches et variés. Pour cela, le PC est défini par une architecture minimale laissant la liberté à chacun de rajouter les périphériques d’entrée/sorties nécessaires à

l’utilisation visée, qu’elle soit familiale ou professionnelle. Un PC est composé par une unité centrale associée à des périphériques (clavier, moniteur, carte d’acquisition, etc…)

6.1 L’unité centrale

Elle est composée par :

6.1.1 La carte mère

La carte mère est l'un des éléments essentiels d'un ordinateur. Elle assure la connexion physique des différents composants (processeur, mémoire, carte d'entrées/sorties, ...) par l’intermédiaire de différents bus (adresses, données et commande). Plusieurs technologies de bus peuvent se côtoyer sur une même carte mère. La qualité de la carte mère est vitale puisque la performance de l’ordinateur dépend énormément d’elle. On retrouve toujours sur une carte mère :

Architecture d’une carte mère

s’occupe d’interfacer le microprocesseur avec les périphériques rapides (mémoire et carte graphique) nécessitant une bande passante élevée alors que le pont sud s’occupe d’interfacer le

microprocesseur avec les périphériques plus lents (disque dur, CDROM, lecteur de disquette, réseau, etc…).

On voit apparaître différents bus chargés de transporter les informations entre le

microprocesseur et la mémoire ou les périphériques :

retrouve plus sur les nouvelles générations de cartes mères.

permettant de relier un maximum de 7 ou 15 périphériques par contrôleur suivant la

révision du protocole utilisée. C’est une interface concurrente à l’IDE qui présente

l’avantage de pouvoir connecter plus de périphériques pour des débits supérieurs. En

outre, ces périphériques peuvent partager le bus lors d’un dialogue contrairement à

l’IDE. Mais son coût reste très élevé… elle est utilisée pour les serveurs.

Dans sa deuxième révision (USB 2.0), il atteint un débit de 60 Mo/s. Un de ces

avantages est de pouvoir connecter théoriquement 127 périphériques. Il supporte de

plus le hot plug-and-play (connexion ou déconnexion de périphériques alors que le

PC fonctionne).

périphériques à des débits très élevés (100 à 400 Mo/s). Ces applications sont

tournées vers la transmission de vidéos numériques.

Chaque fabricant a en effet développé une solution propriétaire pour connecter les

deux composants de leur chipset. Pour Intel, c’est Intel Hub Architecture (IHA) dont

les débits atteignent 533 Mo/s. Pour Nvidia (en collaboration avec AMD), c’est

l’HyperTransport qui atteint des débits de 800 Mo/s.

Remarques :

et seront remplacés par des bus série :

Exemple : Carte mère ASUS A7N8X

Le microprocesseur est bien entendu l’élément essentiel du PC. Nous avons vu que les performances d’un microprocesseur étaient liées à son architecture et sa fréquence de fonctionnement. A l’heure actuelle, le marché des microprocesseurs pour PC est dominé par deux principaux constructeurs : Intel et AMD. Ceux-ci ont adopté deux stratégies différentes pour réaliser des microprocesseurs toujours plus performants. Intel, fort de son savoir faire, a choisi de fabriquer des microprocesseurs toujours plus rapide en terme de fréquence de fonctionnement alors qu’AMD essaie plutôt d’optimiser ses architectures afin qu’elles soient capables d’exécuter toujours plus d’instructions par cycle d’horloge. Ces deux optiques se retrouvent dans les références des microprocesseurs de chaque marque. Lorsqu’Intel désigne chaque nouveau microprocesseur par sa fréquence, AMD préfère utiliser un P-Rating se référant aux performances des microprocesseurs Intel. Chaque fondeur utilise des sockets et des chipsets différents pour leurs microprocesseurs. Ainsi, le choix d’un microprocesseur impose forcément un choix sur un type de carte mère. Pour connaître les performances d’un microprocesseur, il ne faut donc pas se fier à la seule valeur de sa fréquence de fonctionnement. Il faut prendre en compte toutes les caractéristiques liées à son architecture et ne pas oublier de l’entourer d’un chipset et d’une mémoire performants. La dernière chose à ne pas omettre lorsqu’on choisit un microprocesseur est son système de refroidissement. En effet, plus la fréquence augmente et plus la dissipation thermique sera importante. Un microprocesseur mal refroidit peut entraîner des dysfonctionnements au sein du PC voir même la destruction du microprocesseur lui même. Il faut prévoir un système d’air cooling (ventilateur + radiateur ou heat pipe) ou de water cooling (circuit de refroidissement à eau).

Exemple : Microprocesseur haut de gamme Décembre 2004

Exemple : Système de refroidissement

6.1.3 La mémoire

La qualité et la quantité de mémoire d’un PC vont permettre, au même titre que le microprocesseur, d’accroître les performances de celui-ci. Si on dispose d’un microprocesseur

performant, encore faut-il que la mémoire puisse restituer ou sauvegarder des informations aussi

rapidement qu’il le désire. La fréquence de fonctionnement de la mémoire est donc un paramètre

essentiel. De même, si on veut réduire le nombre d’accès aux périphériques de stockage secondaire qui sont très lents (disque dur, CDROM, etc…), il faudra prévoir une quantité mémoire principale suffisante.

Aujourd’hui, toutes les mémoires que l’on retrouve sur les PC sont des RAM dynamiques (DRAM). Elles sont toutes synchronisées sur l’horloge du bus processeur (FSB). Un boîtier mémoire est constitué de 3 éléments fondamentaux qui sont :

ensembles fonctionnaient à 100 MHz. C'est à dire que la cellule mémoire fournissait une information mémoire toutes les 10 ns au buffer d’entré/sortie qui lui même la renvoyait sur le bus à une fréquence de 100 MHz. Comme les DRAM fonctionnent sur 64 bits, on avait une bande passante de 800 Mo/s. Les différentes évolutions de la SDRAM permirent d’atteindre une fréquence de 166 MHz. Actuellement, les technologies de DRAM permettent d’effectuer des accès à la mémoire sur le front montant et descendant de l’horloge (DDR-I

SDRAM) et ainsi de doubler la bande passante mémoire sans en modifier la fréquence de

fonctionnement. Pour cela, il faut bien entendu que la matrice mémoire puisse délivrer 2 informations par cycle d’horloge. Les DDR les plus rapides permettent d’atteindre des fréquences de 200 MHz pour l’accès à la matrice de cellules. Néanmoins, on commence à approcher les limites de fonctionnement du cœur de la mémoire. La prochaine technologie reviendra donc à une fréquence de 100 MHz pour la matrice de cellules mais doublera la fréquence du buffer d’entré/sortie pour compenser (DDR II SDRAM). Il faut donc que le cœur de la mémoire puisse délivrer 4 informations par cycle d’horloge. Tout ceci est rendu possible en divisant le nombre de matrices mémoire. Dans le cas de la SDRAM, la matrice de cellules mémoire est constituée d’un seul bloc physique contre deux pour la DDR-I puis quatre pour la DDR-II.

De plus, de nombreux chipsets permettent de gérer deux canaux d’accès à la mémoire et donc d’accéder simultanément à deux modules de mémoire différents. Le PC sera donc plus performant si il utilise, par exemple, deux barrette de 256 Mo plutôt qu’une seule de 512 Mo. (bus quad pumped d’Intel)

Exemple : Dénomination des mémoires SDRAM

La bande passante est théoriquement doublée si les barrettes sont utilisées en “dual channel”.

Le rôle de la carte graphique est de convertir les données numériques à afficher en un signal

compréhensible par un écran . Alors qu'à ses débuts, la carte vidéo se chargeait uniquement d'afficher une simple image formée de points colorées (pixel), les derniers modèles apparus se chargent d'afficher des images en 3D d'une grande complexité. C’est donc un système à microprocesseur à elle seule qui est composée par :

La carte vidéo communique avec la mémoire centrale et le microprocesseur par l’intermédiaire

d’un bus. Actuellement, c’est le bus AGP qui est le plus utilisé mais il va progressivement être

remplacé par le PCI Express qui présente des débits beaucoup plus élevés (8 Go/s contre 2 Go/s).

Le GPU est le processeur central de la carte graphique.

Il se charge du traitement des données vidéo, permettant ainsi de soulager le microprocesseur. Son rôle est de traiter les objets envoyés par le microprocesseur puis d’en déduire les pixels à afficher. En effet, dans le cas de l’affichage du scène 3D, le microprocesseur communique au GPU les données à afficher sous forme vectorielle. Les objets sont donc définis par une masse de points représentant leurs coordonnées dans l’espace.

Pour afficher un objet à l’écran, le GPU procède en plusieurs étapes :

1. placer les objets dans le repère et leur appliquer des transformations (translation, rotation, etc…)

2. appliquer les effets de lumières sur chaque objet

3. décomposer les objets en petits triangles puis en fragments

4. appliquer des textures et des effets sur les fragments

5. afficher les pixel résultants de l’association des fragments

Pour cela, il est constitué d’un immense pipeline principal. Celui-ci comprend au moins un vertex

shader (étape 1 et 2), un setup engine (étape 3) et un pixel shader (étape 4 et 5).

Remarques :

Pour une image en 1600x1200, cela fait 1 920 000 pixels à calculer, soit près de 6 millions de

fragments !!!! D’autant plus que pour bien faire, le GPU doit être capable d’afficher 50 images/s soit

calculer 300 millions de fragments par seconde… Ceci explique pourquoi les GPU des cartes 3D

récentes sont plus complexes que les derniers microprocesseurs.

Program Interface) qui sont des langages de description et de manipulation des objets :

6.1.4.2 La mémoire vidéo

Elle sert à stocker les images et les textures à afficher. Elle doit présenter des débits très important. Actuellement, la plupart des cartes graphiques sont dotées de DDR SDRAM.

6.1.4.3 Le RAMDAC

Le Ramdac (Random Access Memory Digital Analog Converter) convertit les signaux délivrés

par la carte en signaux analogiques compatibles avec la norme VGA des moniteurs. Plus la fréquence du RAMDAC d'une carte graphique sera élevée, plus le rafraîchissement et la résolution de l'image pourront être élevés. Le confort visuel apparaît à partir d’un rafraîchissement de 72 Hz (fréquence à laquelle sont rafraîchies les lignes à afficher). En principe, la fréquence du RAMDAC est donc de l’ordre de :

Largeur écran x Hauteur écran x fréquence rafraîchissement x 1.32

On rajoute un coefficient de 1.32 à cause du temps perdu par le canon à électron lors de ces déplacements.

Exemple :

Pour une résolution de 1600x1200 à une fréquence de 85Hz, il faudra un RAMDAC de

1600x1200x85x1.32= 215 Mhz !!!

6.1.4.4 Les entrées/sorties vidéo

La sortie vers le moniteur se fait par l’intermédiaire d’une sortie au format VGA. Maintenant, la

plupart des cartes disposent d’une sortie TV au format S-vidéo. Depuis l’explosion des écrans LCD, elles disposent aussi souvent d’un port DVI en plus du port VGA. Le port DVI est numérique et ne nécessite pas la traduction des données par le RAMDAC.

6.1.5 Les périphériques internes de stockage

Ce sont les périphériques de type mémoire de masse. On les appelle ainsi pour leur grande

capacité de stockage permanent. Ces périphériques sont dotés d’un contrôleur permettant de les faire dialoguer avec le microprocesseur. Actuellement, les plus répandus sont l’IDE et le SCSI. Le SCSI présente des débits plus importants que l’IDE (160Mo/s contre 133Mo/s) et permet de connecter plus de périphériques sur le même contrôleur (7 contre 4). Néanmoins, cette technologie étant plus onéreuse, on la retrouve surtout sur des serveurs alors que l’IDE est présent dans tous les PC. A l’heure actuelle, ces deux types de contrôleur sont en fin de vie et sont progressivement remplacés par des contrôleur de type Serial ATA. Ce sont des contrôleurs série dérivés de l’interface IDE qui vont permettent d’atteindre des débits de 600 Mo/s.

Les périphériques internes de stockage sont principalement des périphériques utilisant des supports magnétiques (disque dur) ou optiques (CDROM, DVDROM).

6.1.5.1 Le disque dur

6.1.5.1 Le disque dur Les disques durs sont capables de

stocker des quantités impressionnantes

d'informations, et surtout de les ordonner et

de les retrouver rapidement.

Principe :

Le disque dur est constitué de

plusieurs plateaux empilés, entre lesquels se

déplace un bras comptant plusieurs têtes de

lecture. Chaque plateau est recouvert d'une

surface magnétique sur ses deux faces et

tourne à une vitesse comprise entre 4000 et

15000 tr/min. La tête de lecture/écriture est composée par un aimant autour duquel est enroulée une bobine.

Pour écrire, on fait passer un courant électrique dans la bobine ce qui crée un champ magnétique. Les lignes de champ magnétique traversent la couche d'oxyde et orientent celui-ci en créant de petits aimants dont le sens est donné par le sens du courant dans la bobine.

Pour lire, on fait passer la tête de lecture/écriture sur le support magnétisé qui crée un courant

induit dans la bobine dont le sens indique s'il s'agit d'un 0 ou d'un 1.

Le formatage :

Le formatage : Le formatage de bas niveau permet d'organiser la surface du disque en éléments simples (pistes et secteurs) qui permettront de localiser l'information. Le nombre total de pistes dépend du type de disque. Il est effectué en usine lors de la fabrication du disque. Chaque piste est découpée en secteurs. Toutefois l'unité d'occupation d'un disque n'est pas le secteur, trop petit pour que le système puisse en tenir compte. On utilise alors un groupe d'un certain nombre de secteurs (de 1 à 16) comme unité de base. Ce groupe est appelé Bloc ou Cluster. C'est la taille minimale que peut occuper un fichier sur le disque. Pour accéder à un secteur donné, il faudra donc déplacer l'ensemble des bras et attendre ensuite que ce secteur se positionne sous les têtes. L’accès à un bloc est aléatoire alors que l’accès à un secteur est séquentiel.

Une autre unité de lecture/écriture est le cylindre. Un cylindre est constitué par toutes les

pistes superposées verticalement qui se présentent simultanément sous les têtes de lecture/écriture.

En effet, il est plus simple d'écrire sur les mêmes pistes des plateaux superposés que de déplacer à

nouveau l'ensemble des bras.

Le formatage de haut niveau permet de créer un système de fichiers gérable par un système

d'exploitation (DOS, Windows, Linux, OS/2, etc ...).

La défragmentation :

A mesure que l'on stocke et supprime des fichiers, la répartition des fichiers sur les différents

clusters est modifiée. L'idéal, pour accéder rapidement à un fichier, serait de pouvoir stocker un fichier sur des clusters contigus sur le même cylindre. La défragmentation permet de réorganiser le stockage des fichiers dans les clusters pour optimiser la lecture.

Les caractéristiques :

A noter que les disques durs actuels sont équipés de cache mémoire afin de diminuer les temps

d’accès.

6.1.5.2 Les disques optiques

Le disque optique numérique résulte du travail mené par de nombreux constructeurs depuis

1970. La terminologie employée varie selon les technologies employées et l’on retrouve ainsi les

abréviations de CD (Compact Disk), CDROM (CD Read Only Memory), CDR, (CD Recordable), DVD (Digital Video Disk), DVDROM (DVD Read Only Memory), etc… Le Compact Disc a été inventé par Sony et Philips en 1981 dans le but de fournir un support audio et vidéo de haute qualité. Les spécifications du Compact Disc ont été étendues en 1984 afin de permettre au CD de stocker des données numériques. En 1990 Kodak met au point le CD-R. Un CD est capable de stocker 650 ou 700 Mo de données et 74 ou 80 min de musique. Le taux de transfert d'un CD-ROM est de 150 ko/s, ce qui correspond au taux de transfert d’un lecteur de CD audio. On peut monter jusqu'à 7200 ko/s (48X) avec un lecteur de CDROM.

Principe CD-ROM:

Un CD-ROM est un disque de 12 cm de diamètre composé de plusieurs couches superposées :

plastique résistant et laissant passer la lumière

CD-ROM, CD-R, CD-RW. Le principe de lecture/écriture utilise un rayon infrarouge d'une longueur d'onde de 780 nm.

Lors de la lecture d'un CD, le faisceau laser traverse la couche de

polycarbonate puis rencontre ou non un creux. Lors d’un passage devant un creux, la lumière du laser est fortement réfractée, de telle sorte que la quantité de lumière renvoyée par la couche réfléchissante est minime. Alors que pour un passage devant un plat, la lumière est pratiquement entièrement réfléchie.

Lorsque le signal réfléchi change, la valeur binaire est 1. Lorsque la réflexion est constante, la valeur est 0. A noter que contrairement aux disques durs, un CD n'a qu'une seule piste organisée en spirale.

couche de colorant organique pouvant être brûlé par un laser 10 fois plus puissant que le laser requit pour lire un CD. Cette couche de colorant est photosensible. Lorsqu'elle est soumise à une forte lumière, elle l'absorbe et sa température augmente à plus de 250°, ce qui fait qu'elle brûle localement, et crée des plages brûlées et non brûlées. Les creux et bosses du CD classique sont donc ici remplacés par le passage d'une zone brûlée à une zone non brûlée qui réfléchisse plus ou moins de lumière. Pour les CD-RW, on utilise un alliage métallique qui possède la particularité de pouvoir retrouver son état d’origine en utilisant un laser à 200 degrés (effacement).

Les méthodes d’écriture :

Les techniques de gravures :

Caractéristiques d’un lecteur/graveur :

Principe DVDROM :

Principe DVDROM : Le DVD-ROM (Digital Versatile Disc - Read Only Memory) est apparu en 1997 et est principalement dédié à la vidéo. C’est en fait un CD-ROM dont la capacité est bien plus grande. En effet, la lecture/écriture est effectuée à partir d’un laser rouge (650 et 635 nm) et permet d’obtenir des creux beaucoup plus petits et donc de stocker plus d’informatons. Les deux longueurs d’ondes utilisées permettent de lire/écrire sur des DVD "double couche". Ces

disques sont constitués d'une couchetransparente et d'une couche réflexive et permettent donc de stocker encore plus d’informations sur un seul CD.

Il existe 3 types de DVD réinscriptibles et incompatibles :

Bibliographie

Cours Web :

A brief history of Intel and AMD microprocessors (cours DEUG Université Angers) – Jean-Michel Richer

Architecture Avancée des ordinateurs (cours Supelec Rennes) – Jacques Weiss

Architecture des ordinateurs (cours IUT GTR Montbéliard) – Eric Garcia

Architecture des ordinateurs (cours IUT SRC Marne la Vallée) – Dominique Présent

Architecture des ordinateurs (cours Université Franche Compté) – Didier Teifreto

Architecture des ordinateurs (cours IUP STRI Toulouse)

Architecture des ordinateurs (cours Université de Sherbrooke) – Frédéric Mailhot

Architecture des ordinateurs (cours Polytechnique) – Olivier Temam

Architecture des ordinateurs (cours IUT GTR Villetaneuse) – Emmanuel Viennet

Architecture des ordinateurs (cours DEUG MIAS) – Frédéric Vivien

Architecture des Ordinateurs (cours Licence Informatique USTL) – David Simplot

Architecture des machines et systèmes Informatiques – Joëlle Delacroix

Architectures des processeurs (cours DEUST Nancy) – Yannick Chevalier

Architecture des systèmes à microprocesseurs – Maryam Siadat et Camille Diou

Architecture des systèmes à microprocesseurs (cours IUT Mesures Physiques) – Sébastien Pillement

Architecture Systèmes et Réseaux (cours DEUG 2ième année) – Fabrice Bouquet

Carte graphique (ENIC) – Julien Lenoir

Cours de réseau (cours EISTI) – Bruno Péant

Cours de réseaux (cours Maîtrise Informatique Université Angers) – Pascal Nicolas

Du processeur au système d’exploitation (cours DEUST Nancy) – Yannick Chevalier

Introduction to computer architecture (cours DEUG Université Angers) – Jean-Michel Richer

Les réseaux : introduction (DESS DCISS) – Emmanuel .Cecchet

Les systèmes informatiques (cours CNAM) – Christian Carrez

Sites web :

Fonctionnement des composants du PC

http://www.vulgarisation-informatique.com/composants.php

Cours d’initiation aux microprocesseurs et aux microcontrôleurs

http://www.polytech-lille.fr/~rlitwak/Cours_MuP/sc00a.htm

Architecture des ordinateurs – Université Angers

http://www.info.univ-angers.fr/pub/richer/ens/deug2/ud44/

Les docs de Heissler Frédéric

http://worldserver.oleane.com/heissler/

X-86 secret

http://www.x86-secret.com/

Le cours hardware d’YBET informatique

http://www.ybet.be/hardware/hardware1.htm

Informa Tech

http://informatech.online.fr/articles/index.php

Articles presse :

Mémoire Flash – article Electronique Juillet 98

Les processeurs numériques de signal – article Electronique Janvier 2004

Fonctionnement d’un processeur et d’une carte graphique – article Hardware magazine Novembre

2003

Livres :

Architecture et technologie des ordinateurs (Dunod) – Paolo Zanella et Yves Ligier

Technologie des ordinateurs et des réseaux (Dunod) – Pierre-Alain Goupille

Les microprocesseurs, comment ça marche ? (Dunod) – T. Hammerstrom et G. Wyant

bonne article

RépondreSupprimertrès riche & presque complet.

Merci

Tout à fait !

SupprimerMerci Didier Teifreto pour, c'est magnifique cour dommage qu'il me fasse louper l'année scolaire

RépondreSupprimer